我们的产品和服务

即插即用传感器解决方案

软件捆包

通过购买我们的现货或定制的传感器解决方案,您将可以使用我们的软件,其中包括一些有用的工具。

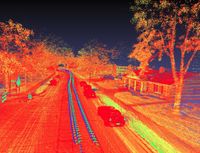

数据可视化器

可视化器可以检查从记录的文件中捕获的数据,并可以将其与后期处理过程中,实时算法中或手动标签中检测到的对象可视化。通过实时可视化和即时时间轴滚动,甚至可以在任何常见的台式机操作系统上轻松查看数百GB的大型记录。由于查看器对所有人免费,因此记录和处理的数据可以与任何人共享和查看。

3D贴标工具和贴标服务

软件开发服务

aCVC,一家计算机视觉公司 UG 首先也是最重要的是一家软件开发公司。 我们是自信的软件工程师并且确信我们可以为各种案例和需求创建出色的产品,比如我们为客户提供软件开发服务。 尽管我们的策略是以特定的招标为目标,但如果您(亲爱的读者)正在寻找软件开发伙伴,可以随时咨询我们的服务,我们可以讨论我们能为您做什么。

计算机视觉领域的相关参考文献组合

深度学习

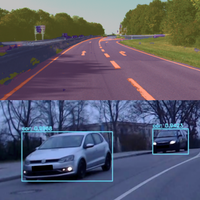

2D物体检测 YOLOnet是该领域最受欢迎的开源项目之一。我们有经验将YOLOnet从v3开始的版本,包括 "微小 "的版本,整合到项目中。

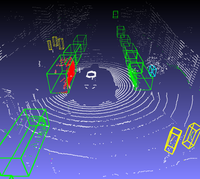

3D物体检测 我们在使用和培训Voxelnet和PointPillars方面有经验,它们适用于各种级别和各种激光雷达扫描仪。这是两个最常用的开源项目,用于激光雷达数据的3D物体检测。PointPillars是这两个项目中较新的一个,根据我们的经验,它能以更短的执行时间实现与Voxelnet非常相似的检测质量。

语义分割 我们在训练和配置PSPNet和SegNet方面都有经验,目的是在各种情况下进行语义图像分割,包括相机和激光雷达传感器。在激光雷达的情况下,点云被结构化为图像,使数据的解析与这些类型的网络兼容。

物体实例分割 我们在训练和配置Mask R-CNN方面都有经验,同时也了解一些用于创建兼容训练数据的常用标记工具的用法。Mask R-CNN既可用于物体检测,也可用于物体实例分割任务。然而,在处理包括激光雷达数据的传感器设置。时,物体实例分割尤其有用

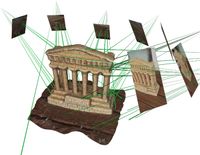

同时进行定位和绘图

激光雷达SLAM 我们正在积极地在我们自己的传感器设置上使用Google Cartographer与Livox Horizon扫描仪,我们已经相应地调整了超参数,以获得可靠和准确的定位。我们还实现了一个可以实时运行的版本,并向其他ROS节点提供实时定位数据。我们还实现了Google Cartographer的配置,可以与采用多个激光雷达的不同传感器设置配合使用。我们在使用和修改伯克利本地化和制图开源项目代码方面也有很多经验。

视觉SLAM 当只有摄像机(或单个摄像机)可用时,我们无法部署上一节的算法。因此,我们已经在一些需要使用视觉SLAM的项目中部署了DSO和ORB-SLAM开源项目。

传感器模拟

Carla是麻省理工学院授权的用于自动驾驶研究的开源模拟器,是自动驾驶和ADAS相关项目的一个重要工具。我们对该工具的主要使用是在该工具提供的各种场景中驾驶一辆自动驾驶汽车,同时生成模拟的原始传感器数据并提取地面真实物体和分割标签。我们用这些来训练深度学习模型,通过允许访问几乎无限的和自动生成的训练数据,这些模型被用于真实传感器数据的物体检测。另一个使用案例是实现避免碰撞的功能,防止控制虚拟汽车的人意外或故意与其他物体相撞。从这些项目中,我们获得了很多关于如何在能够从这种整合中受益的场景中使用这一工具的知识。